激光传感器测量更准确的核心原因源于激光本身的物理特性、信号处理方式以及技术设计的协同作用,具体可从以下几个方面深入解析:

1. 激光的固有物理特性决定了高精度基础

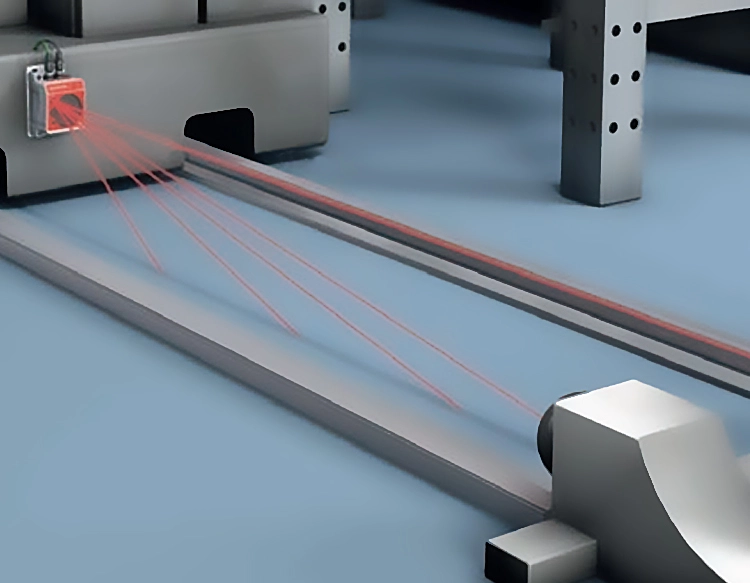

极高的方向性:激光是受激辐射产生的相干光,光束发散角极小(通常仅 0.1 毫弧度以下,相当于 1 公里外光斑直径仅约 10 厘米),能量高度集中。相比之下,红外或超声波的波束发散严重(如红外测距光束可能在 10 米外扩散到数十厘米),容易受到周围物体反射干扰,导致测量点偏移。而激光能精准聚焦于目标点,减少 “误触发” 误差。

单色性与相干性:激光的波长单一且稳定(如常用的 635nm、905nm 激光),受环境光(如阳光、灯光)的干扰极小。例如,在室外强光环境中,红外传感器可能因杂光混入导致信号失真,而激光传感器可通过滤波技术仅接收特定波长的反射光,信噪比显著提升。

光速的稳定性:激光以光速(约 30 万公里 / 秒)传播,其速度在空气中的波动极小(受温度、气压影响可通过算法精确补偿)。相比超声波(速度受空气密度、湿度影响大,误差可达 ±5%),激光的传播速度更易被精确计算,为距离测量(基于 “时间差 × 光速 / 2” 的原理)提供了稳定基准。

2. 信号处理技术进一步降低误差

时间测量的高精度:激光测距的核心是测量激光往返的时间差(TOF 技术)或相位差(相位法)。现代激光传感器采用高精度计时器(如皮秒级时钟,1 皮秒 = 10⁻¹² 秒),即使是微小的时间差也能被捕捉。例如,1 毫米的距离对应约 6.7 皮秒的时间差,先进传感器可分辨这种级别的信号,实现亚毫米级精度。

抗干扰算法优化:通过多脉冲检测、峰值识别等算法,剔除环境中的杂散反射(如灰尘、雾气的漫反射),仅保留目标物体的有效反射信号。例如,在工业车间多粉尘环境中,算法可过滤掉粉尘的干扰脉冲,确保测量值为真实工件距离。

温度与漂移补偿:传感器内置温度传感器和校准芯片,实时修正因温度变化导致的电路延迟、激光波长偏移等误差。例如,高温环境下电路响应速度变化可能引入误差,补偿算法可通过预设的温度 - 误差模型自动修正,确保全温区(如 - 40℃~85℃)内精度稳定。

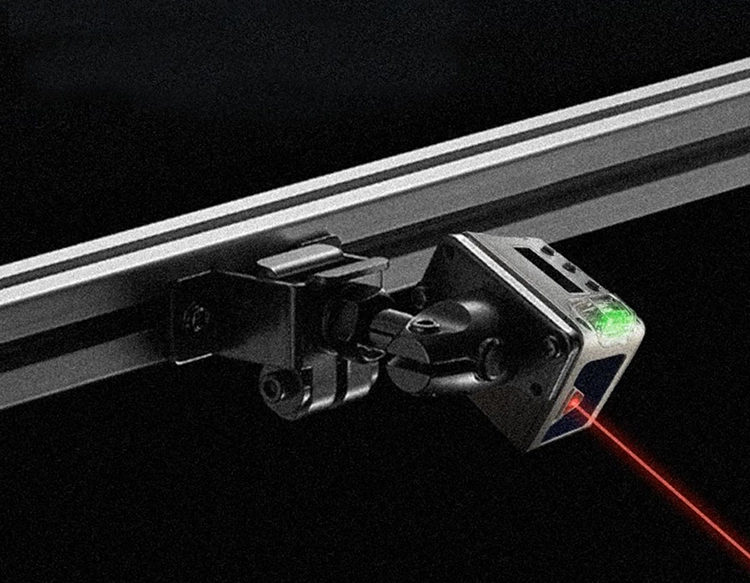

3. 结构设计减少机械与环境误差

光学系统的精密设计:激光发射器与接收器的光路严格对准,配合聚焦透镜将光束压缩至最小光斑,减少目标表面不平整导致的反射偏差。例如,测量粗糙金属表面时,小光斑可避免光斑覆盖凹陷或凸起区域,确保反射信号来自同一平面。

抗振动与冲击设计:工业级激光传感器采用刚性外壳和防震结构,减少机械振动对光路或电路的影响。相比之下,机械接触式传感器(如游标卡尺)可能因振动导致测量头位移,而激光传感器的非接触特性从根本上避免了这类误差。

密封与防护性能:外壳采用 IP67/IP68 等高防护等级设计,防止灰尘、水汽进入光学元件或电路,避免因污染导致的信号衰减或光路偏移,长期保持测量稳定性。